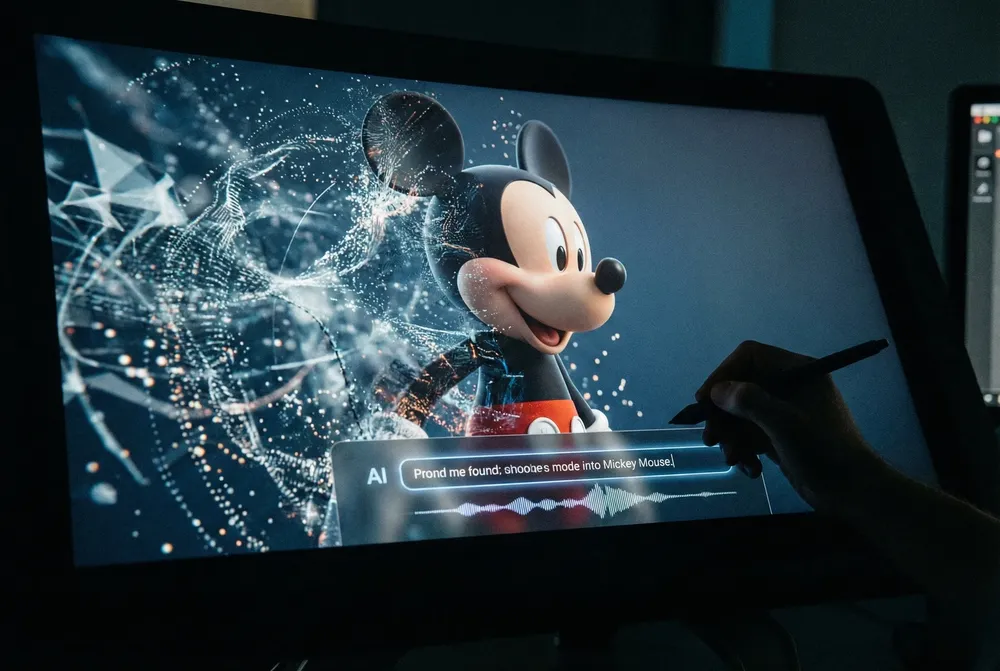

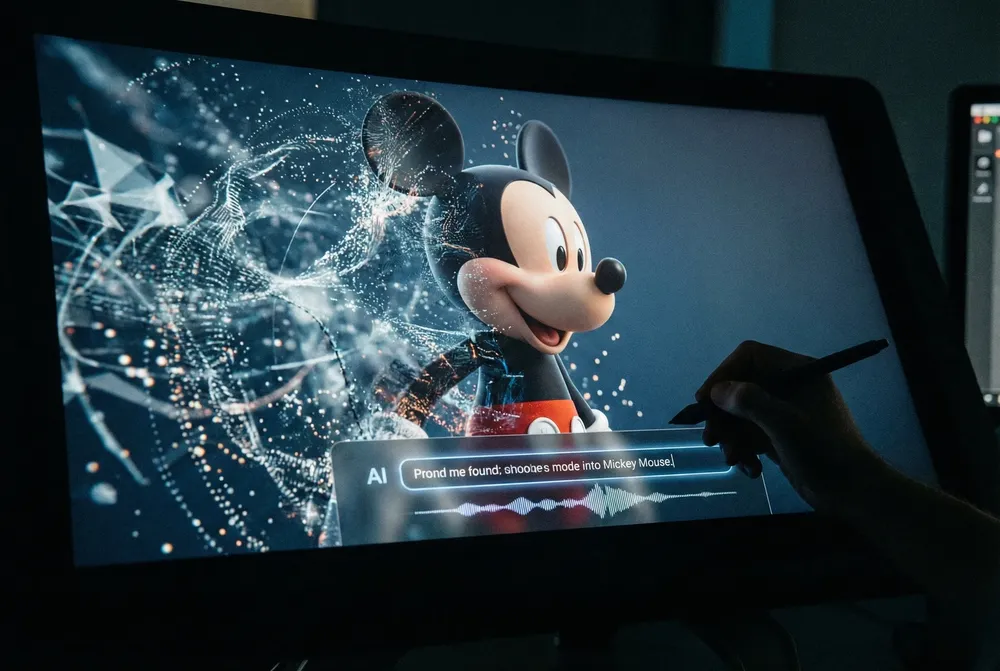

Una alianza de mil millones permitirá a usuarios generar contenido con más de 200 dibujos animados de la empresa.

Eliezer Yudkowsky, responsable del Machine Intelligence Research Institute, fue contundente respecto a los riesgos asociados al desarrollo de esas tecnologías.

Tecno04 de abril de 2023

Pausar los desarrollos de inteligencia artificial no es suficiente, necesitamos frenarlos por completo. El título con evidente tono de advertencia encabeza un artículo firmado en la revista Time por Eliezer Yudkowsky, responsable del Machine Intelligence Research Institute (MIRI) que estudia los avances en IA hace más de dos décadas.

La referencia de Yudkowsky es a la carta que la semana rubricaron personalidades de la industria tecnológica, entre ellos Elon Musk, exigiendo un parate de seis meses en el desarrollo de los sistemas de IA por los riesgos asociados a esos avances, ahora manifiestos en el despliegue de ChatGPT de OpenAI.

En la petición, el grupo de especialistas instó a establecer una moratoria hasta que se establezcan procedimientos seguros, nuevas autoridades reguladoras, vigilancia de los desarrollos, técnicas que ayuden a distinguir entre lo real y lo artificial, e instituciones capaces de hacer frente a la “dramática perturbación económica y política que causará la IA”.

De acuerdo a Yudkowsky, pausar los desarrollos en el área es un paso necesario, aunque no suficiente.

3 datos sobre Eliezer Yudkowsky

En el artículo publicado en Time, el especialista plantea que la carta de los expertos para frenar por seis meses los desarrollos en IA es “demasiado poco” para enfrentar la amenaza que plantean estas tecnologías.

“No podemos calcular por adelantado qué ocurrirá y cuándo, y actualmente parece posible imaginar que un laboratorio de investigación pueda cruzar líneas críticas sin enterarse”, escribió. Según el líder de la organización MIRI, a este ritmo aparecerá un sistema de IA que no haga lo que los humanos deseen y no le importen los seres vivos. “Sería como si el siglo XI intentará batallar contra el siglo XXI”, graficó.

“No estamos preparados. No estamos en el camino de estar significativamente más preparados a corto plazo. Si seguimos así todos moriremos, incluyendo a niños que no eligieron esto y que no hicieron nada malo”, remató Yudkowsky.

Fuente: TN.

Una alianza de mil millones permitirá a usuarios generar contenido con más de 200 dibujos animados de la empresa.

Los administradores podrán activar o desactivar esta opción para que cada usuario recién llegado consulte los debates clave.

El caso abrió un debate inevitable: ¿quién regula a los nuevos juguetes equipados con inteligencia artificial?

La plataforma de video ofrecerá a los usuarios un recap de los contenidos más vistos durante el año. Además, dividirá en "personalidades" a cada internauta, según sus preferencias de entretenimiento.

OpenAI confirmó la existencia del primer prototipo.

WhatsApp rediseñó la sección Info. para mostrar mensajes temporales al estilo de las Notas de Instagram.

En ese contexto nace Overtone, una plataforma que usa inteligencia artificial para conexiones "más reales y profundas", lejos del 'swipe' infinito.

El marfileño, jugador del Villarreal, fue consultado por la eterna comparación entre ambos astros y dejó una analogía inesperada inspirada en Dragon Ball Z que ya es viral en redes.

Será para todos los niveles educativos: inicial, primario, secundario, superior y universitario.

Cuarenta y cinco personas llevan meses trabajando de sol a sol para finalizar la escultura de más de 20 metros de alto en Calcuta; la idea es que el mismo ídolo la descubra este sábado en el inicio de su gira por el país asiático.

La Agencia Córdoba Cultura se suma a la iniciativa que acompaña las celebraciones de fin de año en el centro capitalino.

Conocé las cotizaciones dólar blue, el oficial, el MEP y el CCL.

El acto de apertura se realizó en el natatorio del Parque Sarmiento con la presencia del intendente Daniel Passerini y el secretario de Fortalecimiento Vecinal, Cultura y Deportes, Héctor Campana.

La definición del torneo Clausura, fútbol del Viejo Continente, turf, hockey sobre césped, básquetbol y tenis en el menú deportivo del día.

Gobiernos de Europa, Asia y Oceanía analizan copiar la medida para reducir riesgos de adicción, daño psicológico y exposición a contenidos nocivos.

Estos reforzarán las tareas de conservación y fiscalización en distintos parques nacionales del país.